Nel mondo tech, e non solo, tutti parlano di AI. Un vero e proprio fiume di notizie sull’intelligenza artificiale applicata in ogni campo, dall’individuare la paternità di un vecchio dipinto, al camion senza conducente utilizzato dall’esercito degli Stati Uniti. Tuttavia in mezzo a questa frenesia, un aspetto che sta sfuggendo alla nostra attenzione sono i modi in cui l’intelligenza artificiale può essere utilizzata per fini criminali, in particolare in relazione alla sicurezza dei dati. In che modo la corporate governance può affrontare le sfide future e arginare le minacce derivanti da usi malevoli dell’intelligenza artificiale?

In che modo l’AI influenzerà la sicurezza dei dati digitali?

All’inizio del 2018, 26 esperti mondiali di sicurezza provenienti, fra gli altri, dall’Università di Oxford, l’Università di Cambridge e il Centro per la New American Security, si sono riuniti per determinare il presente e il futuro malevolo dell’AI. Il risultato del loro report di 100 pagine è uno sguardo realistico sul ruolo a cui sono chiamati i professionisti della sicurezza informatica e della corporate governance. Prima d’ora, il focus sull’AI era estremamente positivo con paesi e aziende pronti a spendere miliardi nella corsa per il dominio sull’Intelligenza Artificiale. Ma con questa analisi i ricercatori non solo stanno facendo luce sugli usi criminali dell’intelligenza artificiale, ma stanno anche sollevando domande scomode sulla governance, e di conseguenza anche sulla corporate governance. L’analisi fa notare in modo chiaro come “l’AI eliminerà il trade-off tra la portata e l’efficienza degli attacchi e consentirà attacchi su larga scala, mirati e altamente efficienti”.

Questa innovativa ricerca prevede anche nuove modalità in cui l’intelligenza artificiale potrà ridisegnare gli attacchi informatici e minare la sicurezza dei dati in futuro, “hacking automatizzato, sintesi vocale utilizzata per impersonare obiettivi, e-mail di spam finemente mirate utilizzando informazioni scaricate dai social media o sfruttando le vulnerabilità degli stessi sistemi di intelligenza artificiale (ad esempio attraverso esempi contraddittori e avvelenamento dei dati).

SFIDE ALL’ORIZZONTE

L’intelligenza artificiale renderà più difficile la sicurezza dei dati. Si tratta di una dura verità. L’AI Now Institute della New York University, impegnata a studiare le implicazioni sociali dell’intelligenza artificiale, nella sua “Relazione AI 2017” ha sottolineato come la corporate governance possa affrontare questo e altri problemi.

Ecco i nostri punti chiave estratti dalla ricerca:

1: Aumentare il numero dei soggetti coinvolti attivamente nei progetti di intelligenza artificiale

La corporate governance dovrebbe definire un gruppo di lavoro dedicato appositamente a prevenire e mitigare i rischi legati all’intelligenza artificiale.

2: Gli studi legali non dovrebbero più utilizzare AI “black box” e algoritmi

L’ AI institute ha sottolineato come l’uso di tali sistemi “sollevi serie preoccupazioni in merito alla conformità delle procedure seguite”, e quindi i dipartimenti legali dovrebbero essere soggetti a controlli pubblici, test, audit e standard di responsabilità.

3: Il software di AI deve essere rigorosamente rivisto e testato prima dell’uso

L’ AI institute consiglia che vengano definiti fin dall’inizio degli standard, per capire e monitorare meglio i problemi legati all’adozione del nuovo software.

4: Essere cauti nell’utilizzo dell’AI all’interno delle Risorse Umane

Sono necessarie maggiori politiche per l’utilizzo dei sistemi di intelligenza artificiale da parte delle risorse umane, in particolare nel processo di assunzione. I ricercatori hanno segnalato il potenziale impatto sui diritti del lavoro e sulle procedure seguite, ad esempio, parzialità nella selezione.

5: Essere selettivi con le soluzioni software

Uno dei modi migliori in cui la governance aziendale può contrastare gli attacchi informatici che utilizzano tecnologie di intelligenza artificiale consiste nell’affidarsi a prodotti software sicuri che siano all’avanguardia. DiliTrust fornisce soluzioni software che si concentrano sul fornire non solo un prodotto di qualità, ma anche altamente sicuro. Le nostre soluzioni sono costantemente soggette a tre tipi di rigorosi test di sicurezza e aggiornamenti costanti. In questo modo, i nostri clienti possono contare su di noi per dare sempre la priorità alla sicurezza dei loro dati.

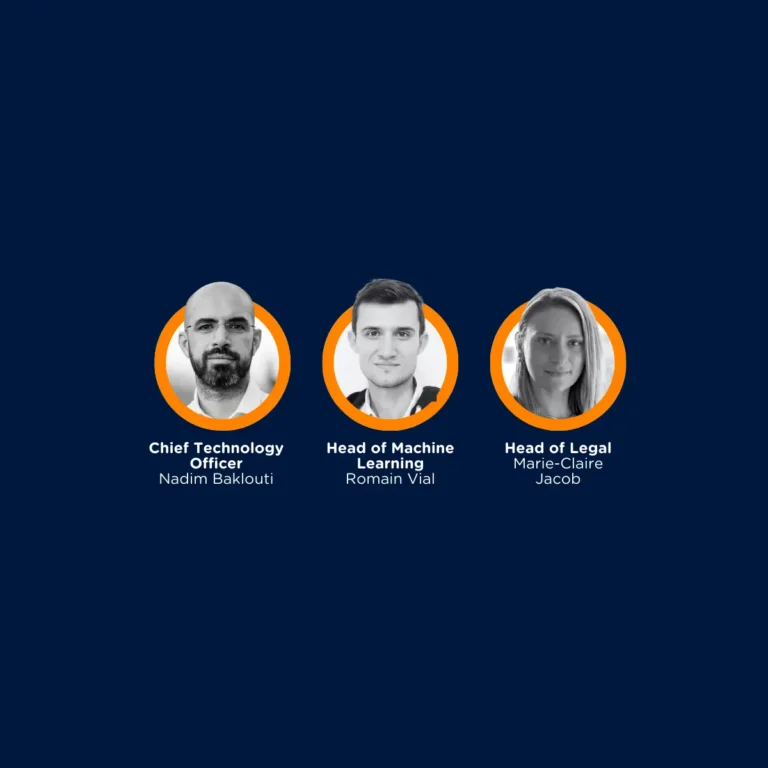

Contatta il nostro team per avere maggiori informazioni.